VAK Russia 12.00.01

VAK Russia 12.00.10

VAK Russia 12.00.12

VAK Russia 12.00.14

UDC 34

CSCSTI 10.07

Russian Library and Bibliographic Classification 60

Russian Trade and Bibliographic Classification 7340

The article analyzes the risks and new opportunities that arise before man and modern society in the light of the development of artificial intelligence and robotics in the conditions of the fourth industrial revolution. The rapid development of AI indicates the absence of uniform approaches to assessing the risks and prospects associated with the use of AI. Using PESTEL analysis, the article examines the key areas of interaction between AI and humans, new challenges and prospects that open to humanity in the era of new technologies.

artificial intelligence, human-machine symbiosis, machine learning, robotics, work displacement

Работа выполнена при финансовой поддержке Гранта Президента РФ № НШ-2668-2020.6 «Национально-культурные и цифровые тренды социально-экономического и политико-правового развития Российской Федерации в XXI веке».

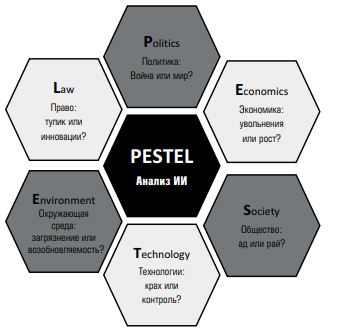

Искусственный интеллект (ИИ) быстро становится частью нашей повседневной жизни, предлагая бесчисленные выгоды для общества, происходит трансформация общественных отношений под воздействием развития технологий ИИ. Это ставит перед обществом и государством ряд важнейших вопросов в области регулирования данного феномена. Быстрое развитие ИИ позволяет сделать вывод об отсутствии единообразных подходов к оценке рисков, связанных с использованием ИИ. Рассмотрим ИИ с точки зрения потенциальных угроз при его использовании с помощью анализа PESTEL. PESTEL-анализ — это инструмент, предназначенный для выявления политических (political), экономических (economic), социальных (social), технологических (technological), экологических (environmental) и юридических (legal) аспектов внешней среды, которые влияют на исследуемый объект. Понимание потенциального будущего ИИ позволит правительствам, корпорациям и обществу в целом комплексно оценить риски и быть готовыми к новым вызовам.

Русский писатель Александр Солженицын однажды сказал, что «линия, разделяющая добро и зло, пересекает сердце каждого человека». То же самое можно сказать и об искусственном интеллекте. Учитывая актуальность этого явления, неясно, как добро и зло проявят себя в мире ИИ. Проиллюстрируем шесть ключевых проблем ИИ, используя метод PESTEL [3]. На рис. 1 эта структура применяется к ИИ.

Рис. 1. PESTEL-анализ искусственного интеллекта

1. Политика: война или мир?

Существует множество способов использования ИИ и робототехники в военных целях [16, с. 341–358]. Это касается не только военных роботов и автономных дронов, но и экзоскелетов, которые увеличивают силу и выносливость солдат-людей. Основные правовые и нравственно-этические проблемы возникают при передаче автономной интеллектуальной системе вооружений правомочия принимать критические решения, в особенности если основной целью такой системы является причинение вреда [10, с. 12]. И речь здесь не только о несовершенстве ИИ, но и о возможности манипулирования устройствами с помощью взлома, помимо того, что они могут сами отклониться от правильного пути из-за возможных проблем алгоритма и т.п. Возможно использовать и более тонкие методы и повлиять на процесс голосования, как показали примеры Cambridge Analytica и Facebook на президентских выборах 2016 г. в США. Британская компания Cambridge Analytica, созданная в 2013 г., собрала личные данные 50 млн пользователей Facebook, затем она смоделировала поведение десятков миллионов американцев для того, чтобы показывать им релевантную политическую рекламу, тем самым, как считается, повлияв на результаты выборов.

Однако эти примеры не должны создавать ложное впечатление, что ИИ несет исключительно вред. Ведь можно использовать военного робота, например, для нанесения минного поля на карту или исследовать неизвестное здание, а не полагаться на людей-военных, которые в процессе могут и погибнуть. Помимо того, что ИИ может использоваться как инструмент влияния, на него также можно положиться, чтобы помочь людям принимать лучший вариант решения. Давно известно, что люди не идеальны в принятии решений [12, c. 263–291; 13, c. 453–458]. Уже существуют такие инструменты, как RoboVote [24], чтобы помочь людям сделать выбор, например определить лучшую партию для голосования с учетом их предпочтений. Стоит также упомянуть системы предиктивной аналитики, использующиеся в сфере правоприменения, судопроизводства и правоохранительной деятельности. (Palantir, COMPAS, Harm Assessment Risk Tool, ePOOLICE и др.). Еще один интересный факт на тему аутсорсинга принятия решений: недавний опрос, проведенный Центром управления изменениями (Center for the Governance of Change) в IE University в Испании, показал, что 25% европейцев предпочли бы, чтобы политические решения принимались ИИ, а не политиками [7, c. 6].

2. Экономика: увольнения или рост?

Кажется, что в какой-то момент любое обсуждение ИИ приходит к проблеме сокращения рабочих мест и вопросу о том, нужны ли еще работники-люди, если машины могут делать всё. Основной аргумент прозвучал почти столетие назад, когда в 1930 г. Джон Кейнс представил концепцию технологической безработицы [14]. В своем знаменитом исследовании «Будущее занятости» Фрей и Осборн [8, c. 254–280] отметили, что 47% всех рабочих мест в США могут быть автоматизированы в течение 10–20 лет. Зогнер считает, что ожидаемые изменения трудового статуса, такие как потеря работы, понижение в должности или необходимость сменить профессию, обычно объясняются высоким риском компьютеризации соответствующих видов деятельности. Интересно, что к предпринимательству, индивидуальному либо связанному с использованием наемных работников, чаще переходят лица, чьи специальности сохраняют «устойчивость» к роботизации. Так, подъем предпринимательской активности обусловлен скорее не сокращением рабочих мест в связи с автоматизацией, а новыми возможностями, появляющимися в цифровую эпоху [23, c. 37–48].

В то время как некоторые исследователи утверждают, что технологические изменения всегда разрушали одни рабочие места и создавали другие взамен, есть мнение, что достаточно продвинутая система ИИ может справляться с задачами эффективнее людей и с меньшими финансовыми затратами [5, c. 51–70]. В таком случае почему кто-то всё еще хочет нанимать людей, если машина справится лучше? Когда автомобили стали более распространены, лошади, которые в то время были основным видом транспорта, практически исчезли с наших улиц. Возможно, кого-то пугает подобная перспектива и для человека.

Однако такой негативный прогноз маловероятен. Среднестатистический сотрудник выполняет десятки, если не сотни различных задач в день, и лишь немногие из них могут быть фактически выполнены машинами. Учитывая высокую стоимость покупки системы искусственного интеллекта, а также ее настройки и обслуживания, маловероятно, что предприятия заменят людей машинами, если эти машины смогут выполнять только часть своей работы. Другие виды занятости, в том числе те, которые связаны с выполнением межличностных и эмпатических задач, вероятно, станут еще более важными в будущем [11, c. 43–65]. Всемирный экономический форум 2018 предсказал, что в течение следующих 5 лет посредством ИИ будет создано более 50 млн новых рабочих мест [26]. Вполне вероятно, что будущее автоматизации заключается в улучшении работы, а не в замене человека [18, c. 84–109], когда системы искусственного интеллекта берут на себя рутинные и однообразные задачи, которые люди предпочитают не выполнять в первую очередь, по крайней мере в краткосрочной и среднесрочной перспективе.

3. Общество: ад или рай?

Две проблемы, которые создают напряжение в обществе сегодня, — это рост неравенства и одиночества. ИИ, скорее всего, окажет влияние на обе. Хотя технологические изменения, которые будут инициированы ИИ, могут не привести к исчезновению рабочих мест, они, скорее всего, отделят производительность предприятия от производительности труда. Следовательно, увеличение производительности, вызванное ИИ, может не принести одинаковой выгоды всем, что приведет к росту неравенства. Было показано, что норма прибыли на капитал, как правило, выше, чем темпы экономического роста [21], и ИИ, вероятно, еще больше увеличит этот разрыв. Согласно прогнозам Всемирного экономического форума этот рост неравенства является самой большой социальной проблемой робототехнической революции.

Кроме того, ИИ может привести к усилению изолированности человека, если, например, медсестры заменяются роботами по уходу как следствие нехватки рабочей силы в больницах, учреждениях социального обслуживания или домах престарелых. Но посмотрим на ситуацию с другой стороны. Во всё более стареющем обществе проблема одиноких граждан, особенно пожилых, будет становиться всё более острой. Социализация роботов является неизбежным процессом, соответствующим не только технологической динамике «обыскусствления» всех человеческих функций (труд, память, зрение и т.д.), но и культурным механизмам обучения и передачи опыта [1, с. 173]. Роботы, такие как Pepper, полугуманоидный робот, производимый Softbank Robotics, уже оснащены ИИ, который позволяет им обнаруживать эмоции и реагировать соответствующим образом. Хотя они и не идеальны, они могут оказаться очень полезными для людей, которые иначе были бы ограничены в социальных контактах. В области медицины ИИ также может помочь в прогнозировании серьезных рисков для здоровья, таких как рак кожи и инсульты. Тогда возникает вопрос: если система искусственного интеллекта может с полной уверенностью определить, какое заболевание вы получите в следующем десятилетии и какое заболевание может вас убить, хотели бы вы знать? Или лучше пребывать в неведении?

4. Технологии: крах или контроль?

В мире, в котором ИИ будет контролировать всё больше сфер деятельности, как люди могут гарантировать, что они всё еще держат руку на пульсе? Сценарий со «злым роботом», конечно, экстремальный, но есть много других вариантов развития событий, когда ИИ может выйти из-под контроля.

Во-первых, система ИИ может просто неправильно интерпретировать запрос пользователя, воспринимать его слишком буквально или не понять контекста. В качестве примера можно вспомнить виртуального собеседника Tay, который предназначен для ведения дружеских бесед языком 19-летней девушки. Но машина не смогла распознать императивы «дружеский» и «разумный», установленные разработчиками, поэтому виртуальный собеседник подавал расистские, сексистские и просто оскорбительные реплики [15]. Или, если когда-нибудь появится система ИИ, которую можно было бы попросить спасти мир или принести мир во всем мире, вполне эффективным может оказаться искоренение людей. Каким бы умным ни казался ИИ, его всё равно можно сделать глупым, если интерпретировать нечеткие человеческие требования.

Во-вторых, системы ИИ могут быть предвзятыми изначально. Работа ИИ — это интерпретация внешних данных и их изучение [20]. Если внешние данные, используемые для обучения ИИ, необъективны (например, потому что они были получены с использованием предвзятой эвристики), то такая предвзятость будет перенесена или даже усилена в системе ИИ [19, c. 555–556]. Например, было установлено, что система COMPAS для прогнозирования риска повторного совершения правонарушения предсказывает более высокие значения риска для чернокожих обвиняемых (и более низкие для белых), чем оказывается в действительности [4] (расовая предвзятость). В другом случае было установлено, что рекламный инструмент Google для целевой рекламы позволяет показывать значительно меньше объявлений о высокооплачиваемых работах для женщин, чем для мужчин [6, c. 92–112] (гендерная предвзятость). Тем не менее само выявление предвзятости было признано дискриминацией даже при условии привлечения для этого экспертов высокого уровня и средств правовой защиты [17, c. 4656–4674].

В-третьих, как только системы ИИ будут становиться всё более производительными и, следовательно, более сложными, людям будет всё труднее их понимать. Искусственные нейронные сети и глубокое обучение — лишь некоторые из наиболее распространенных инструментов машинного обучения, используемых в ИИ, — по своей сути являются черным ящиком [15]. Это, в принципе, открывает возможность для ИИ перехитрить человека. Люди смогли управлять планетой не потому, что самые быстрые или сильные, а потому, что самые умные. Если мы больше не самые умные, как мы можем обеспечить контроль?

5. Окружающая среда: загрязнение или возобновляемость ресурсов?

Каждое серьезное изменение в экономике оказывает значительное воздействие на окружающую среду. Сельскохозяйственная революция, которая помогла людям бороться с голодом, привела к исчезновению целых лесов, чтобы освободить место для сельского хозяйства, и выбросу огромных количеств углекислого газа (например, от разведения крупного рогатого скота). Промышленная революция привела к зависимости от ископаемого топлива и связанному с этим изменению климата. К сожалению, ИИ не освобожден от этой закономерности. Серверы, которые выполняют вычисления в облаке или хранят большие данные, требуют огромного количества энергии для охлаждения. И как только они устаревают, они генерируют электронные отходы, переработка которых влияет на здоровье человека и наносит еще больший вред окружающей среде.

Тем не менее вполне возможно, что выгоды от использования ИИ перевесят эти затраты. Человечество сталкивается с серьезными проблемами, среди которых наиболее заметно изменение климата, которое, кажется, трудно решить, используя имеющиеся подходы. ИИ в этом контексте может изменить ситуацию [25, c. 1–6]. Используя свою систему глубокого обучения ИИ, Google удалось сократить расходы на охлаждение своих центров обработки данных на 40% — производительность, которую было бы трудно достичь при использовании более традиционных подходов. В Норвегии ИИ помог создать гибкую энергетическую сеть, которая объединяет больше возобновляемых источников энергии, чем раньше [22, c. 62–77]. Сегодня предприятия должны обращать внимание и на экологическую составляющую своего бизнеса, а не только сосредоточить свое внимание на максимизации прибыли. Всё больше и больше фирм получают сертификаты B-корпорации, а для этого нужно учитывать не только интересы акционеров, но и интересы сотрудников и общества в целом, а также окружающей среды. Вероятно, ИИ может быть союзником в сбережении природы и борьбе с изменением климата в результате человеческой деятельности.

6. Право: тупик или инновации?

Легко заметить, что ИИ и внешние данные неразрывно связаны. Это сулит как минимум две глобальные юридические проблемы. Первая — это вопрос конфиденциальности. Питер Флейшер, консультант по защите персональных данных корпорации Alphabet Inc., отметил, что новой проблемой, связанной с развитием методов машинного обучения, является возможность машин находить способы деанонимизации данных [9]. Алгоритм ИИ обучается на больших массивах данных, которые могут включать деперсонифицированную информацию о людях (пол, возраст, заболевания, рабочий стаж и т.д.). Проблема состоит в том, что ИИ способен при совместном анализе двух и более анонимизированных баз деанонимизировать данные этих баз. Иными словами, алгоритм ИИ может при совместном анализе двух деанонимизированных баз установить конкретного человека. Помимо этого различные приложения и программы всевозможных гаджетов могут собирать информацию о владельце (разговоры, местоположение, поисковые запросы и т.д.). Законодатель может оказаться в сложном положении относительно защиты персональных данных; слишком слабое регулирование может неизбежно привести к нарушению гражданских прав [2], в то время как чрезмерное может побудить фирмы перевести свои инвестиции в ИИ в другую юрисдикцию.

Вторая проблема — это ответственность. Причинение вреда жизни или здоровью в процессе эксплуатации систем ИИ не является редкостью. В настоящее время дискуссии об ответственности за деликты, основанные ранее на сугубо теоретических примерах, основываются на фактах. Так, в 2018 г. самоуправляемый автомобиль Uber сбил насмерть женщину в США. Автопилот не знал, что пешеходы могут нарушать правила дорожного движения. Интересно, что в ходе испытаний самоуправляемых автомобилей Uber с сентября 2016 по март 2018 г. беспилотники компании попали в 37 аварий. Кто должен нести ответственность, если система ИИ принимает решение, которое приносит вред? Разработчик основного алгоритма? Производитель программного обеспечения? Владелец базы данных, которая предоставила внешние данные для обучения системы или клиент, который купил и использовал систему? В деле причинения вреда беспилотной машиной Uber стороны заключили мировое соглашение. Однако очевидно, что развитие машинного обучения делает эту проблему одной из наиболее неотложных, требующей юридического разъяснения. Так, например, предлагается рассматривать систему искусственного интеллекта как животное и привлекать владельца или собственника к ответственности за любой причиненный вред. В качестве альтернативы системы ИИ могут получить свои собственные права. Например, такой подход некоторые юрисдикции уже использовали в отношении природных явлений. Новая Зеландия в 2017 г. признала статус реки Уангануи в качестве юридического лица. Также нельзя не упомянуть, что в 2017 г. роботу Софии было предоставлено гражданство в Саудовской Аравии и резидентство умному боту Shibuya Mirai в Токио (Япония).

Сегодня ИИ стал частью нашей повседневной жизни, нашего мира. Мира, в котором роботы могут выйти из-под контроля, мы все скоро останемся без работы, потому что ИИ может делать всё лучше и быстрее, чем мы, и неравенство достигнет новых уровней. Но в то же время мира, в котором ИИ поможет нам бороться с изоляцией, сотрудникам больше не придется заниматься рутинными задачами, и у нас может быть есть шанс найти решение проблем, которые мы не можем решить сегодня. Поэтому взгляд на ИИ исключительно как на угрозу однобок и не соответствует реалиям нашей жизни. ИИ прежде всего открывает для людей новые возможности и перспективы, что, разумеется, не отменяет благоразумности и предусмотрительности человека в отношении этого достижения науки и технологий.

1. Galkin D.V. Foundations of social robotics in the context of social and humanitarian research. Bulletin of Omsk State University. 2014, no. 2(72). URL: https://cyberleninka.ru/article/n/osnovaniya-sotsialnoy-robototehniki-v-kontekste-sotsialno-gumanitarnyh-issledovaniy (accessed 15 March 2020).

2. Digital security of the individual, society and state in the context globalization: legal mechanisms of ensuring. Review of the session in the framework of SPIEF 2019. A.I. Ovchinnikov, O.V. Akhrameeva, S.A. Vorontsov et al. Bulletin of the faculty of law of the southern Federal University. 2019, no. 2, pp. 111-122.

3. Aguilar F.J. Scanning the business environment. Macmillan. New York. 1967.

4. Angwin J., Larson J., Mattu S., Kirchner L. Machine bias. ProPublica. 2016. May 23.

5. Atack J., Margo R., Rhode P. “Automation” of manufacturing in the late nineteenth century: The hand and machine labor study. The Journal of Economic Perspectives. 2019, no. 33(2), pp. 51-70. DOI:https://doi.org/10.1257/jep.33.2.51.

6. Datta A., Tschantz M.C., Datta A. Automated experiments on ad privacy settings. Privacy Enhancing Technologies. 2015, no. 1, pp. 92-112.

7. European Tech Insights 2019. Center for the Governance of Change. 2019. URL: https://docs.ie.edu/cgc/European-Tech-Insights-2019.pdf.

8. Frey C.B., Osborne M.A. The future of employment: How susceptible are jobs to computerisation? Technological Forecasting and Social Change. 2017, no. 114, pp. 254-280. DOI:https://doi.org/10.1016/j.techfore.2016.08.019.

9. Gardner S. Artificial Intelligence Poses Data Privacy Challenges. Bloomberg Law Privacy and Data Security. 2016. URL: https://www.bna.com/artifi cial-intelligence-poses-n57982079158/.

10. Geiss R. The International-Law Dimension of Autonomous Weapons Systems. International Dialogue department of the Friedrich-Ebert-Stiftung. 28 p. URL: http://library.fes.de/pdf-files/id/ipa/11673.pdf.

11. Huang M.-H., Rust R.T., Maksimovic V. The feeling economy: Managing in the next generation of AI. California Management Review. 2019, no. 61(4), pp. 43-65. DOI:https://doi.org/10.1177/0008125619863436.

12. Kahneman D., Tversky A. Prospect theory: An analysis of decision under risk. Econometrica. 1979, no. 47(2), pp. 263-291.

13. Kahneman D., Tversky A. The framing of decisions and the psychology of choice. Science. 1981, no. 211(4481), pp. 453-458.

14. Keynes J.M. Economic Possibilities for Our Grandchildren. In: Essays in Persuasion. Palgrave Macmillan. London. 1930.

15. Kissinger H. Henry Kissinger argues that A.I. could mean the end of human history. The Atlantic. 2018. URL: https://www.theatlantic.com/magazine/archive/2018/06/henry-kissinger-ai-could-mean-the-end-of-human-history/559124/?utm_source=twitter&utm_medium=social&utm_campaign=share.

16. Leveringhaus A. What’s so bad about killer robots? Journal of Applied Philosophy. 2018, no. 35(2), pp. 341-358. DOI:https://doi.org/10.1111/japp.12200.

17. Manzi G., Forster M. Biases in bias elicitation. Communications in Statistics - Theory and Methods. 2019, no. 48(18), pp. 4656-4674.

18. Metcalf L., Askay D., Rosenberg L. Keeping humans in the loop: Pooling knowledge through artificial swarm intelligence to improve business decision making. California Management Review. 2019, no. 61(4), pp. 84-109. DOI:https://doi.org/10.1177/0008125619862256.

19. Morstatter F., Pfeffer J., Liu H. When is it biased? Assessing the representativeness of twitter's streaming API. In WWW (companion volume). 2014, pp. 555-556.

20. Ntoutsi E., Fafalios P., Gadiraju, U. et al. Bias in data-driven artificial intelligence systems - An introductory survey. WIREs Data Mining Knowl Discov. 2020, no. e1356. URL: https://doi.org/10.1002/widm.1356.

21. Piketty T. Capital in the twenty-first century. Harvard University Press. Cambridge. MA. 2014.

22. Porter M. Creating shared value. Harvard Business Review. 2011, no. 89(1/2), pp. 62-77.

23. Sorgner A. The Automation of Jobs: A Threat for Employment or a Source of New Entrepreneurial Opportunities? Foresight and STI Governance. 2017, no. 11(3), pp. 37-48. DOI:https://doi.org/10.17323/2500-2597.2017.3.37.48.

24. Spice B. RoboVote helps groups make decisions using AI-driven methods. URL: https://www.seas.harvard.edu/news/2016/11/robovote-helps-groups-make-decisions-using-ai-driven-methods.

25. VoPham T., Hart J.E., Laden F., Chiang Y.-Y. Emerging trends in geospatial artificial intelligence (geoAI): Potential applications for environmental epidemiology. Environmental Health. 2018, no. 17(40), pp. 1-6.

26. World Economic Forum. Machines will do more tasks than humans by 2025 but robot revolution will still create 58 million net new jobs in next five years. 2018. URL: https://www.weforum.org/press/2018/09/machines-will-do-more-tasks-than-humans-by-2025-but-robot-revolution-will-still-create-58-million-net-new-jobs-in-next-five-years/.